En 2016, el profesor de Oxford Luciano Floridi intentó interesar a la UE en la ética de la inteligencia artificial.

“El número de personas que me dijeron que eso no era un problema, que les estaba haciendo perder el tiempo, es notable”, recordó Floridi a finales de 2020.

-

Los académicos críticos con las Big Tech tienen menos probabilidades de optar a puestos financiados por empresas tecnológicas que los académicos tecnopositivos (Foto: Infocux Technologies)

Perseveró. En los años siguientes, cuando la Comisión Europea se dispuso a regular la IA, el profesor de ética se convirtió en uno de los principales expertos que asesoraban a la Comisión.

Pero Floridi, como muchos otros expertos que asesoraban a la UE, tenía amplios vínculos de financiación con las grandes empresas tecnológicas, lo que planteaba dudas sobre posibles conflictos de intereses y la enorme influencia de los intereses empresariales en la política de IA de la UE.

Asesoramiento de expertos por sectores

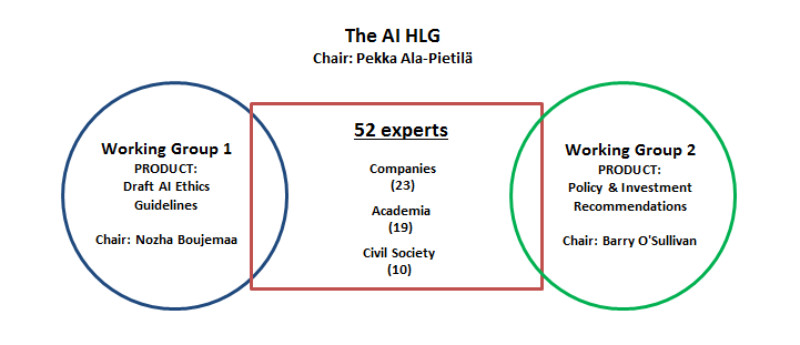

En 2018, la Comisión Europea creó un “grupo de expertos de alto nivel” (HLEG) que asesoraría a la UE sobre las directrices éticas y la política de inversión para la inteligencia artificial.

A pesar de la responsabilidad de redactar las directrices éticas de la UE, pocos de los miembros del grupo de expertos eran especialistas en ética. De hecho, 26 expertos -casi la mitad de los 56 miembros del grupo- representaban intereses empresariales.

El resto estaba formado por 21 académicos, tres organismos públicos y seis organizaciones de la sociedad civil.

Google e IBM se sentaron a la mesa junto a grandes empresas europeas como Airbus, BMW, Orange y Zalando. A través de DigitalEurope, una asociación empresarial a la que pertenecen la mayoría de las grandes empresas tecnológicas, las grandes tecnológicas contaban con otro defensor directo en el grupo.

Para Cecilia Bonefeld-Dahl, directora de DigitalEurope y antigua ejecutiva de IBM, el grupo de expertos era “un grupo multipartito muy diverso con miembros de todo tipo de procedencias”. La directora de DigitalEurope se proclamó “firme partidaria de esta diversidad”.

Otros no estaban de acuerdo.

“Sólo seis personas en representación de la sociedad civil es muy, muy bajo”, dijo Thibault Weber, que representaba a la Confederación Europea de Sindicatos, organización que agrupa a los sindicatos europeos.

“No fue un proceso democrático en absoluto”, continuó Weber. “La Comisión nombró al grupo [and] ni siquiera conocemos los criterios”. La CES de Weber luchó por conseguir un puesto en el grupo y sólo fue admitida cuando un sindicato filial se retiró para hacerles sitio.

Documentos internos revelan que la UE había previsto inicialmente más expertos de la sociedad civil y menos representantes de las empresas.

Preguntado por la composición del grupo, un portavoz de la UE destacó la “multidisciplinariedad, amplia experiencia, diversidad de puntos de vista y equilibrio geográfico y de género” de los miembros. El funcionario explicó el escaso número de especialistas en ética afirmando que “el intenso trabajo del grupo no se centró únicamente en la ética.”

Académicos financiados por la tecnología

La información disponible públicamente revela que al menos nueve de los académicos y representantes de la sociedad civil del grupo de expertos estaban afiliados a instituciones que tenían vínculos de financiación con Big Tech, a menudo por valor de millones de euros. Esto incluía instituciones académicas, como la TU Munich, INRIA, TU Vienna, Fraunhofer Institute, TU Delft, y DFKI.

Luciano Floridi lleva mucho tiempo vinculado a Big Tech: un perfil sobre Floridi, que él mismo retuiteó, se refería a él como el “filósofo de Google”.

El Laboratorio de Ética Digital de la Universidad de Oxford, dirigido por Floridi, está financiado por Google y Microsoft. Para un artículo sobre los principios de la IA, publicado durante su estancia en el grupo de expertos de la UE, declaró haber recibido financiación directa de Google y Facebook.

En 2019, mientras también estaba en el grupo de expertos de la UE, Floridi se unió al consejo asesor de Google para el desarrollo responsable de la inteligencia artificial, aunque Google canceló el consejo apenas una semana después de su anuncio tras las protestas públicas.

Otro académico del grupo de expertos de la UE, Andrea Renda, ocupó la “Cátedra Google de Innovación Digital” en el Colegio de Europa, que ofrece prestigiosos cursos de posgrado sobre la UE, desde 2017 hasta 2020 -durante toda su participación en el grupo de expertos de la UE.

Al mismo tiempo, Renda trabajó como investigador principal en el Centro de Estudios Políticos Europeos (CEPS), un influyente grupo de reflexión de Bruselas con docenas de miembros corporativos, entre ellos Google, Facebook y Microsoft, a un precio de 15.000 euros al año.

Los tres gigantes tecnológicos formaron parte de un grupo de trabajo del CEPS sobre IA, presidido por Renda, que habló de “la enorme promesa” de la inteligencia artificial, a pesar de los “desafíos”. Más recientemente, Renda dirigió un estudio del CEPS sobre el impacto de la propuesta de reglamento de la UE sobre IA.para la comisión.

Declaración de intereses

Los peritos nombrados a título personal deben actuar “con independencia y en interés público” y no tener conflictos de intereses.

Floridi y Renda no veían ningún conflicto de intereses entre la financiación y su papel como expertos. Floridi comentó que “toda mi labor de investigación y asesoramiento se lleva a cabo con plena libertad académica y sin influencia de los financiadores.”

Renda explicó que “ninguna de estas dos actividades interfería realmente con mi pertenencia al HLEG: yo era un miembro independiente y actuaba como tal, contribuyendo de forma muy proactiva al trabajo del HLEG.”

Había “solicitado con éxito” el puesto en el Colegio de Europa que Google financiaba, y Google no había participado en el proceso de selección ni había interferido nunca en sus actividades. “Como académico, realmente no tomo partido por ningún poder privado o público”, dijo Renda.

Otros académicos afirman que la financiación sí influye. Mohamed Abdalla, de la Universidad de Toronto, dijo que “el dinero no cambia necesariamente el punto de vista de alguien”, pero hay “autoselección”.

Los académicos críticos con las grandes tecnológicas tienen menos probabilidades de optar a puestos financiados por empresas tecnológicas que los académicos favorables a la tecnología.

Según Abdalla, que ha comparado las estrategias de lobby de Big Tech con las de Big Tobacco, “la cuestión es la sobreinflación de ese punto de vista en el mundo académico o en la formulación de políticas.”

No está claro si algún experto declaró tener intereses contrapuestos; la comisión denegó una solicitud de las declaraciones de independencia de los expertos alegando que contenían datos personales. Tampoco está claro si la comisión verificó la ausencia de conflicto de intereses.

El grupo de defensa de los derechos digitales Access Now, una de las pocas organizaciones de la sociedad civil del grupo, también recibe financiación de empresas tecnológicas.

Daniel Leufer, analista de políticas europeas de Access Now, dijo que la organización había denunciado el predominio de la industria en el grupo y había presionado para que se establecieran normas y líneas rojas.

Pero se trata de un delicado equilibrio. “Somos muy críticos cuando hay motivos para la crítica, pero tampoco somos un grupo de presión antitecnológico”, añadió Leufer. “No hay blanco o negro, y trabajamos con las empresas tecnológicas para asegurarnos de que mejoran sus prácticas”.

Luke Stark, un académico canadiense que rechazó la financiación de Google, dijo que el hecho de que en la investigación de la IA sea casi imposible mantenerse alejado de la financiación de la industria es un problema enorme. “Realmente explica gran parte del lío en el que estamos metidos con estos sistemas”.

Vínculos entre Big Tech y expertos ajenos a la empresa

Pase el ratón por encima de los elementos individuales para ver sus conexiones o selecciónelos directamente para obtener más información. También puede ampliar las descripciones haciendo clic en los tres puntos de la izquierda (en el ordenador) o en la parte inferior del visual (versión móvil). Nos hemos puesto en contacto con todos los miembros del grupo de expertos que aparecen en la visualización y hemos incluido sus comentarios, si los hemos recibido.

Líneas rojas” diluidas

La dependencia de las herramientas de las grandes tecnologías también suscitó inquietud en el grupo de expertos. En una de sus primeras reuniones, el grupo de expertos se enzarzó en una acalorada discusión.

El tema: ¿podría el grupo utilizar Google Docs para colaborar?

“No me lo podía creer”, dijo un experto. “Si hay un grupo que no puede trabajar en Google docs, es el grupo de expertos en IA de la UE”. Al final, el grupo decidió trabajar con otro sistema.

Según las fuentes, surgió otro debate cuando el representante de Google, Jacob Uszkoreit, propuso copiar y pegar una parte de las directrices éticas de Google en las recomendaciones de la UE.

“Las directrices en sí no tienen nada de malo, pero lo que Google hace en la práctica no está bien, y eso es lo que enfureció a la gente”, dijo Sabine Köszegi, profesora de la Universidad Técnica de Viena. “Dijimos ‘lo sentimos, pero no'”, recordó Thiébault Weber, de la CES.

Quizá la muestra más evidente de influencia se produjo cuando el grupo de expertos estudió la posibilidad de establecer líneas rojas, es decir, aplicaciones de la IA que la UE prohibiría rotundamente.

Se había pedido a Thomas Metzinger, un especialista alemán en ética, que dirigiera el grupo de trabajo sobre líneas rojas. Tras varias reuniones, Pekka Ala-Pietilä, presidente del grupo y antiguo ejecutivo de Nokia, le dijo que eliminara cualquier referencia a usos “no negociables” de la IA.

Los representantes de la industria, según Metzinger, dieron un ultimátum: “esta palabra no estará en el documento, o nos vamos”. Las líneas rojas desaparecieron del orden del día.

En su lugar, el grupo identificó “oportunidades y preocupaciones críticas planteadas porAI” y recomendó siete “requisitos clave”, como la seguridad, la transparencia y la no discriminación, que tendría que cumplir la IA.

Según Ursula Pachl, experta de la Organización Europea de Consumidores (BEUC), las recomendaciones del grupo en materia de regulación “acabaron siendo una parte bastante diluida del informe general”.

Y las recomendaciones “suavizadas” del grupo de expertos no eran vinculantes. Sólo cinco de los siete principios se utilizaron en el reglamento sobre IA que la Comisión propuso en abril de 2021.

Se excluyeron dos: la Comisión de la UE, en una sigilosa nota a pie de página, escribió que “el bienestar medioambiental y social son principios a los que se puede aspirar” pero “demasiado vagos para un acto jurídico y demasiado difíciles de hacer operativos.”

Auditoría AI

A medida que el debate sobre el reglamento de la IA se ha trasladado al pleno del Parlamento Europeo, muchos de los expertos se han dedicado a nuevos proyectos.

Para Luciano Floridi, la auditoría de los sistemas de IA parece ser la nueva frontera.

“Hemos pasado de los principios a las prácticas, a los requisitos, a las normas, y adivina qué pasa después: alguien se lo toma como un negocio”, dijo el profesor de Oxford a finales de 2020.

Floridi afirmó que está en contacto con “algunas empresas importantes” que quieren “ganar mucho dinero” haciendo “auditorías de IA como servicio, una vez que entren en juego las normativas blandas o duras. Así que, atentos a ese espacio”.

Google, Microsoft, Jacob Uszkoreit y Cecilia Bonefeld-Dahl no respondieron a nuestras peticiones de comentarios.

Facebook, ahora rebautizado y reorganizado bajo la empresa paraguas Meta, dijo: “Apoyamos la investigación independiente y el debate público sobre cómo la tecnología, incluida la IA, afecta a la sociedad. Cuando hacemos contribuciones financieras para avanzar en el debate público, no vinculamos nuestras contribuciones a posiciones específicas o resultados de investigación.”