Aquellos de nosotros que hemos pasado las últimas décadas informando sobre tecnología hemos visto modas y modas que suben y bajan en las burbujas de inversión.

A fines de la década de 1990, fueron las empresas de punto com, más recientemente criptografía, blockchain, NFT, automóviles sin conductor, el “metaverso”. Todos han tenido su día en el sol en medio de promesas que cambiarían el mundo, o al menos la banca y las finanzas, las artes, el transporte, la sociedad en general. Hasta la fecha, esas promesas se encuentran espectacularmente incumplidas.

Eso nos lleva a los chatbots de inteligencia artificial.

Desde octubre pasado, cuando levanté una bandera roja sobre la exageración en el campo de la inteligencia artificial, el entusiasmo de los inversores solo ha crecido exponencialmente (al igual que los temores del público).

Wall Street y los inversionistas de riesgo están invirtiendo miles de millones de dólares en nuevas empresas de inteligencia artificial: solo Microsoft realizó una inversión de $ 10 mil millones en OpenAI, la empresa que produjo el bot ChatGPT.

Las empresas que buscan capital han aprendido que solo necesitan reclamar una conexión de IA para atraer inversores a sus puertas, al igual que las nuevas empresas escribieron “punto com” en sus planes de negocios hace un par de décadas. Nvidia Corp. ha adquirido un valor de mercado de un billón de dólares gracias a un chip que fabrica y que se considera crucial para el procesamiento de datos requerido por los chatbots de IA.

Los promotores de la IA están entusiasmados con las capacidades de sus productos (y las ganancias potenciales).

Aquí está el capitalista de riesgo Marc Andreessen: Entre las ventajas de “nuestra nueva era de IA”, escribió recientemente, “cada niño tendrá un tutor de IA que es infinitamente paciente, infinitamente compasivo, infinitamente informado, infinitamente útil”; cada persona “un asistente/entrenador/mentor/entrenador/asesor/terapeuta de IA”; cada científico “un asistente/colaborador/socio de IA”; cada líder político el mismo ayudante superinteligente.

No hay mucho que decir sobre esta predicción, aparte de que es entrañable en su ingenuidad infantil, dado que en el mundo actual todavía no podemos obtener conexiones de Internet de banda ancha, que se originaron en la década de 1990, para millones de estadounidenses. ¿Le sorprendería saber que la empresa de riesgo de Andreessen ha invertido en más de 40 empresas relacionadas con la IA? Yo tampoco.

Andreessen también escribió: “Cualquier cosa que la gente haga hoy con su inteligencia natural se puede hacer mucho mejor con la IA”.

Eso es probablemente falso. Los ejemplos de IA que confunden las expectativas de sus usuarios se han acumulado casi semanalmente.

Entre los casos más famosos está el de un abogado de Nueva York que presentó un escrito en una demanda judicial federal citando o citando docenas de demandas ficticias generadas por ChatGPT. Cuando el juez le ordenó al abogado que verificara las citaciones, le preguntó a ChatGPT si eran reales, lo que es un poco como preguntarle a una madre joven si su bebé es el bebé más adorable que haya existido. El bot dijo, seguro que lo son, otra “alucinación”.

Al final, el abogado y sus asociados fueron multados con $ 5,000 y se les ordenó escribir cartas de disculpa abyectas a las partes contrarias y a todos los jueces que el bot había identificado falsamente con los casos falsos. También perdió el juicio.

Abundan los informes de otros fiascos similares. Una asociación de trastornos alimentarios reemplazó a los humanos que atienden su línea de ayuda con un chatbot, posiblemente como un movimiento antisindical, pero luego tuvo que desconectar el bot porque, informó Vice, estaba alentando a las personas que llamaban a adoptar “hábitos alimenticios poco saludables”.

Un profesor de Texas suspendió a toda una clase porque ChatGPT había afirmado ser el autor de sus artículos. La administración de la universidad exoneró a casi todos los estudiantes después de que demostraron que el bot estaba equivocado; alguien incluso envió la tesis doctoral del profesor al bot, que afirmó haberla escrito también.

Las afirmaciones hechas sobre las habilidades o los peligros de los chatbots de IA a menudo han resultado ser erróneas o quiméricas.

Un equipo de investigadores del MIT pretendió descubrir que ChatGPT podría sobresalir en el plan de estudios de matemáticas e informática de la escuela con “una tasa de resolución perfecta” en las pruebas de las materias; su hallazgo fue desacreditado por un grupo de estudiantes del MIT. (El documento original se ha retractado). Un informe revelador de que un programa de IA en una simulación de la Fuerza Aérea “mató” a su operador humano para perseguir sus objetivos programados (estilo HAL) resultó ser ficticio.

Por lo tanto, es útil observar de cerca lo que los chatbots de IA pueden y no pueden hacer. Podemos empezar con la terminología. Para estos programas, “inteligencia artificial” es un nombre inapropiado. No son inteligentes en el sentido en que los humanos y los animales son inteligentes; simplemente están diseñados para parecer inteligentes para un extraño que desconoce los procesos electrónicos que ocurren en su interior. De hecho, usar el mismo término distorsiona nuestra percepción de lo que están haciendo.

Ese problema fue notado por Joseph Weizenbaum, el diseñador del chatbot pionero ELIZA, que reprodujo las respuestas de un psicoterapeuta de manera tan convincente que incluso los sujetos de prueba que sabían que estaban conversando con una máquina pensaron que mostraba emociones y empatía.

“De lo que no me había dado cuenta”, escribió Weizenbaum en 1976, “es que exposiciones extremadamente cortas a un programa de computadora relativamente simple podrían inducir pensamientos delirantes poderosos en personas bastante normales”. Weizenbaum advirtió que la “antropomorfización imprudente de la computadora”, es decir, tratarla como una especie de compañera pensante, había producido una “visión simplista… de la inteligencia”.

Incluso las computadoras más avanzadas no tenían la capacidad de adquirir información más que “alimentadas con cuchara”, escribió Weizenbaum. Eso es cierto para los chatbots de hoy, que adquieren sus datos “raspando” el texto que se encuentra en la web; es solo que su capacidad para atiborrarse de datos es mucho mayor ahora, gracias a las mejoras exponenciales en el poder de cómputo, que en 1976.

Los chatbots que atraen tanto interés hoy en día son lo que los investigadores de IA denominan IA “generativa”, que utiliza reglas estadísticas para responder consultas mediante la extrapolación de los datos que han adquirido previamente.

En el fondo, dice el tecnólogo australiano David Gerard, ChatGPT es “un autocompletado extraordinariamente ampliado”, como un programa de procesamiento de textos que predice el final de una palabra o una oración que ha comenzado a escribir. El programa “simplemente arroja combinaciones de palabras basadas en grandes cantidades de texto de capacitación”.

El entusiasmo profesional por estos programas, las predicciones de que nos han acercado un paso más a la verdadera inteligencia artificial, o que son capaces de aprender, o que albergan el potencial de destruir a la raza humana, puede parecer sin precedentes.

Pero no lo es. Las mismas predicciones engreídas, lo que Weizenbaum llamó “fantasías grandiosas”, han sido parte del mundo de la IA desde sus inicios. En 1970, Marvin Minsky del MIT, uno de los padrinos de la IA, le dijo a Time que “dentro de tres a ocho años tendremos una máquina con la inteligencia general de un ser humano promedio… una máquina que podrá leer Shakespeare, engrasar un coche, jugar a la política de oficina, contar un chiste y pelear… En unos meses, estará a nivel de genio y unos meses después sus poderes serán incalculables”.

Minsky y sus contemporáneos finalmente tuvieron que reconocer que los programas que parecían mostrar un potencial ilimitado eran aptos solo dentro de límites estrechos. Eso sigue siendo cierto.

ChatGPT puede producir poesía tonta o ensayos para estudiantes de primer y segundo año, aprobar exámenes sobre algunos temas técnicos, escribir comunicados de prensa, compilar documentos legales con una apariencia de profesionalismo.

Pero todas estas son clases genéricas de escritura; las muestras producidas por humanos en estas categorías a menudo tienen una cualidad robótica vacía. Cuando se les pide que produzcan algo verdaderamente original o creativo, los chatbots fallan o, como descubrieron esos desventurados abogados, fabrican. (Cuando Charlie Brooker, creador de la serie de televisión “Black Mirror”, le pidió a ChatGPT que escribiera un episodio, el producto era de una calidad que describió con un epíteto que no se puede publicar).

Eso puede hacer que las empresas se detengan con la esperanza de contratar chatbots para reducir sus nóminas humanas. Cuando descubren que pueden tener que contratar trabajadores para examinar la salida del chat para evitar atraer la ira de los clientes o incluso demandas judiciales, es posible que no estén tan ansiosos por dar a los bots incluso responsabilidades de rutina, y mucho menos tareas de misión crítica.

A su vez, eso puede insinuar el destino del frenesí inversor actual. “La primavera optimista de la IA de la década de 1960 y principios de la de 1970”, escribe Melanie Mitchell del Instituto Santa Fe, dio paso al “invierno de la IA” en el que colapsaron la financiación del gobierno y el entusiasmo popular.

Otro auge, esta vez sobre los “sistemas expertos”, se materializó a principios de la década de 1980, pero se desvaneció a fines de la década. (“Cuando recibí mi doctorado en 1990, me recomendaron que no usara el término ‘inteligencia artificial’ en mis solicitudes de empleo”, escribe Mitchell). Cada década parecía tener su auge y su caída.

¿La IA es realmente amenazante? Incluso las aterradoras advertencias emitidas sobre los peligros de la tecnología y la necesidad de regulación parecen campañas promocionales disfrazadas. Su motivo oculto, escribe Ryan Calo de la Universidad de Washingtones “centrar la atención del público en un escenario descabellado que no requiere muchos cambios en sus modelos comerciales” y convencer al público de que la IA es excepcionalmente poderosa (si se implementa de manera responsable).

Curiosamente, Sam Altman, director ejecutivo de OpenAI, ha presionado a la Unión Europea para que no “regule en exceso” su negocio. Las regulaciones de la UE, como suele suceder, se centrarían en cuestiones a corto plazo relacionadas con la pérdida de puestos de trabajo, las infracciones de la privacidad y las violaciones de los derechos de autor.

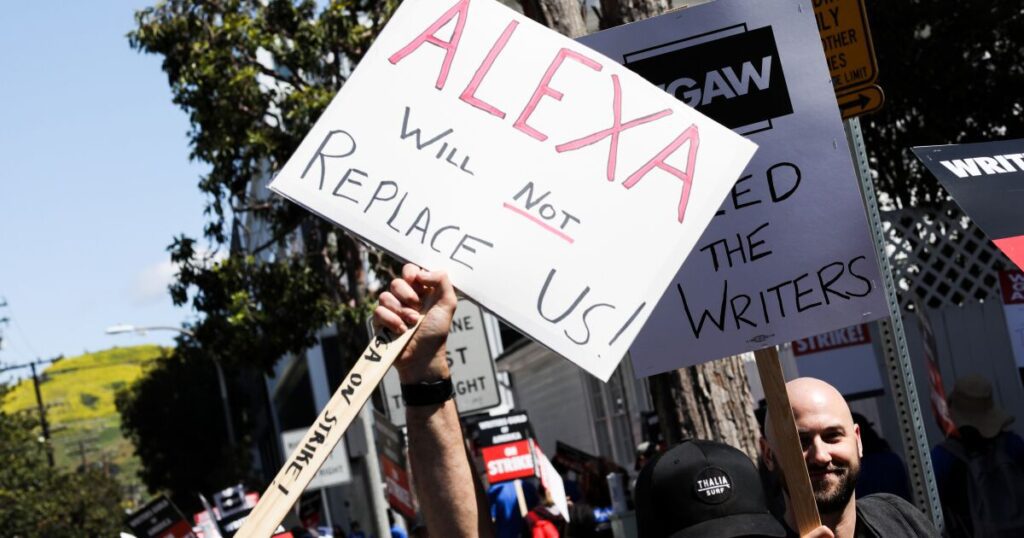

Algunas de esas preocupaciones son las motivaciones de la huelga de escritores que se está llevando a cabo ahora en Hollywood y la posible huelga de actores, que podría ocurrir tan pronto como el viernes: los miembros del sindicato están debidamente preocupados de que puedan perder el trabajo debido a los bots de IA explotados por productores tacaños y directores de estudio que piensan que el público es demasiado tonto para saber la diferencia entre la creatividad humana y la robótica.

Lo que apenas reconocen los empresarios de IA de hoy, como sus predecesores, es lo difícil que será pasar de la clase actual de chatbots a la inteligencia artificial genuina.

La imagen de la inteligencia humana como el mero producto de los cien billones de conexiones neuronales en el cerebro humano: un número insondable. por el cerebro humano— lleva a algunos investigadores de IA a suponer que una vez que sus programas alcancen esa escala, sus máquinas se volverán conscientes. Son los últimos problemas difíciles para lograr la inteligencia, y mucho menos la conciencia, los que pueden ser insuperables: los investigadores humanos ni siquiera se han puesto de acuerdo sobre una definición de inteligencia y no han podido identificar el asiento de la conciencia.

¿Hay un papel razonable en nuestras vidas para los chatbots? La respuesta es sí, si se consideran herramientas para aumentar el aprendizaje, no para hacer trampa; los maestros están preocupados por identificar las tareas generadas por chat, pero con el tiempo usarán las mismas técnicas que tienen para identificar el plagio, comparando el producto con lo que saben de las capacidades de sus estudiantes y rechazando aquellas que parecen demasiado pulidas (o tienen identificables). errores).

ChatGPT puede ayudar a estudiantes, escritores, abogados y médicos a organizar grandes cantidades de información o datos para ayudar a aclarar las ideas o producir ideas creativas. Puede ser útil de la misma manera que los profesores inteligentes aconsejan a los estudiantes que utilicen otros recursos web con limitaciones obvias, como Wikipedia: pueden ser el primer lugar que se consulta al preparar una tarea, pero mejor que no sea el último.