La fotografía computacional de Apple busca el realismo

AppleInsider puede obtener una comisión de afiliación por las compras realizadas a través de los enlaces de nuestro sitio.

Una controversia con las cámaras de los teléfonos Samsung ha renovado la conversación en torno a la fotografía computacional, y pone de relieve la diferencia entre ella, y el enfoque de Apple en iOS.

No es un gran secreto que Apple recurre a algoritmos avanzados y a la fotografía computacional para casi todas las funciones de la cámara de su iPhone. Sin embargo, los usuarios están empezando a preguntarse dónde trazar la línea entre estos algoritmos y algo más intrusivo, como la alteración de píxeles posterior a la captura.

En este artículo, vamos a examinar la controversia en torno a las fotos de la luna de Samsung, cómo la empresa aborda la fotografía computacional, y lo que esto significa para Apple y sus competidores en el futuro.

Fotografía computacional

La fotografía computacional no es un concepto nuevo. Se hizo necesaria cuando la gente quiso sacar más rendimiento a las diminutas cámaras de sus smartphones.

La idea básica es que los ordenadores pueden realizar miles de millones de operaciones en un momento, como después de pulsar el disparador de una cámara, para sustituir la necesidad de realizar ediciones básicas o aplicar correcciones más avanzadas. Cuanto más podamos programar el ordenador para que haga después de pulsar el obturador, mejor será la foto.

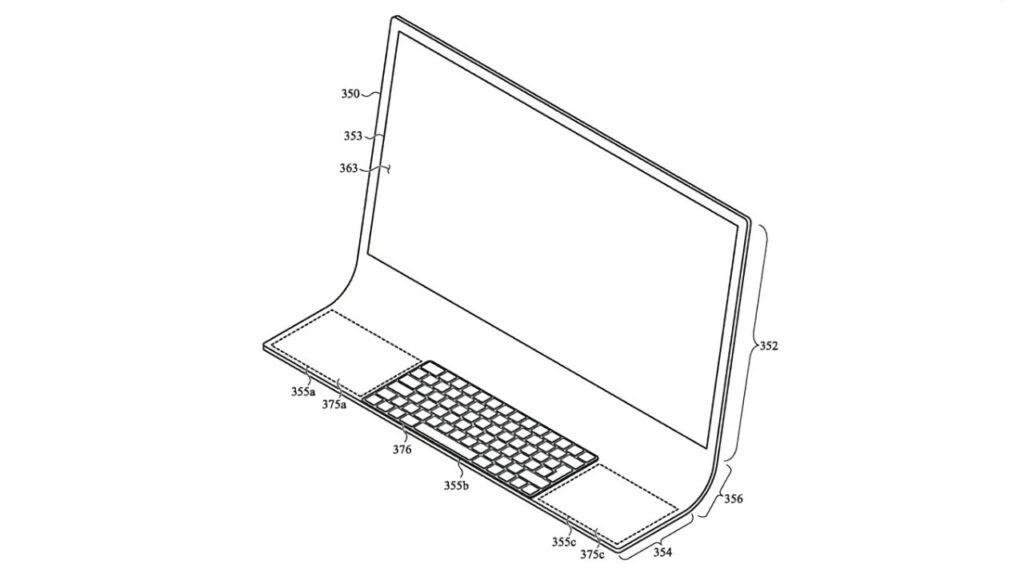

Esto empezó con el sistema de doble cámara de Apple en el iPhone 7. Otras innovaciones fotográficas anteriores, como Live Photos, podrían considerarse fotografía computacional, pero el Modo Retrato fue el punto de inflexión para Apple.

Apple presentó el Modo Retrato en 2016, que tomaba los datos de profundidad de las dos cámaras del iPhone 7 Plus para crear un bokeh artificial. La compañía aseguraba que era posible gracias al sistema de doble cámara y al avanzado procesador de señal de imagen, que realizaba 100.000 millones de operaciones por foto.

Ni que decir tiene que no era perfecto, pero sí un paso hacia el futuro de la fotografía. La tecnología de las cámaras seguiría adaptándose al formato de los smartphones, los chips serían más rápidos y los sensores de imagen más potentes por pulgada cuadrada;

El modo Retrato utiliza la fotografía computacional para separar el primer plano

En 2023, no es inaudito grabar vídeos cinematográficamente borrosos utilizando motores de computación avanzados con resultados dispares. La fotografía computacional está en todas partes, desde el Motor Fotónico hasta los Estilos Fotográficos: un algoritmo procesa cada foto tomada en el iPhone. Sí, incluso ProRAW.

Todo esto fue necesario por el deseo de la gente de capturar su vida con el dispositivo que tenían a mano: su iPhone. Las cámaras dedicadas tienen la física de su lado con grandes sensores y lentes gigantes, pero la persona promedio no quiere gastar cientos o miles de dólares en un equipo dedicado.

Así que la fotografía computacional ha intervenido para mejorar lo que pueden hacer los diminutos sensores de los smartphones. Algoritmos avanzados basados en grandes bases de datos informan al procesador de señal de imagen sobre cómo capturar la imagen ideal, procesar el ruido y exponer un sujeto;

Sin embargo, hay una gran diferencia entre utilizar la fotografía computacional para mejorar las capacidades de la cámara y alterar una imagen basándose en datos que el sensor nunca captó.

El moonshot de Samsung

Para que quede claro: Apple está utilizando modelos de aprendizaje automático -o “IA, Inteligencia Artificial” para los que utilicen la nueva palabra de moda popular mal acuñada- para la fotografía computacional. Los algoritmos proporcionan información sobre el control de las capturas de varias imágenes para obtener los mejores resultados o crear perfiles de profundidad de campo.

El procesador de imágenes analiza el tono de la piel, los cielos, las plantas, las mascotas y otros elementos para proporcionar la coloración y la exposición adecuadas, no la sustitución de píxeles. No busca objetos, como la luna, para proporcionar mejoras específicas basadas en información externa al sensor de la cámara.

Señalamos esto porque quienes debaten sobre las fotos de la luna de Samsung han utilizado la fotografía computacional de Apple como ejemplo de cómo otras empresas realizan estas alteraciones fotográficas. Eso simplemente no es el caso.

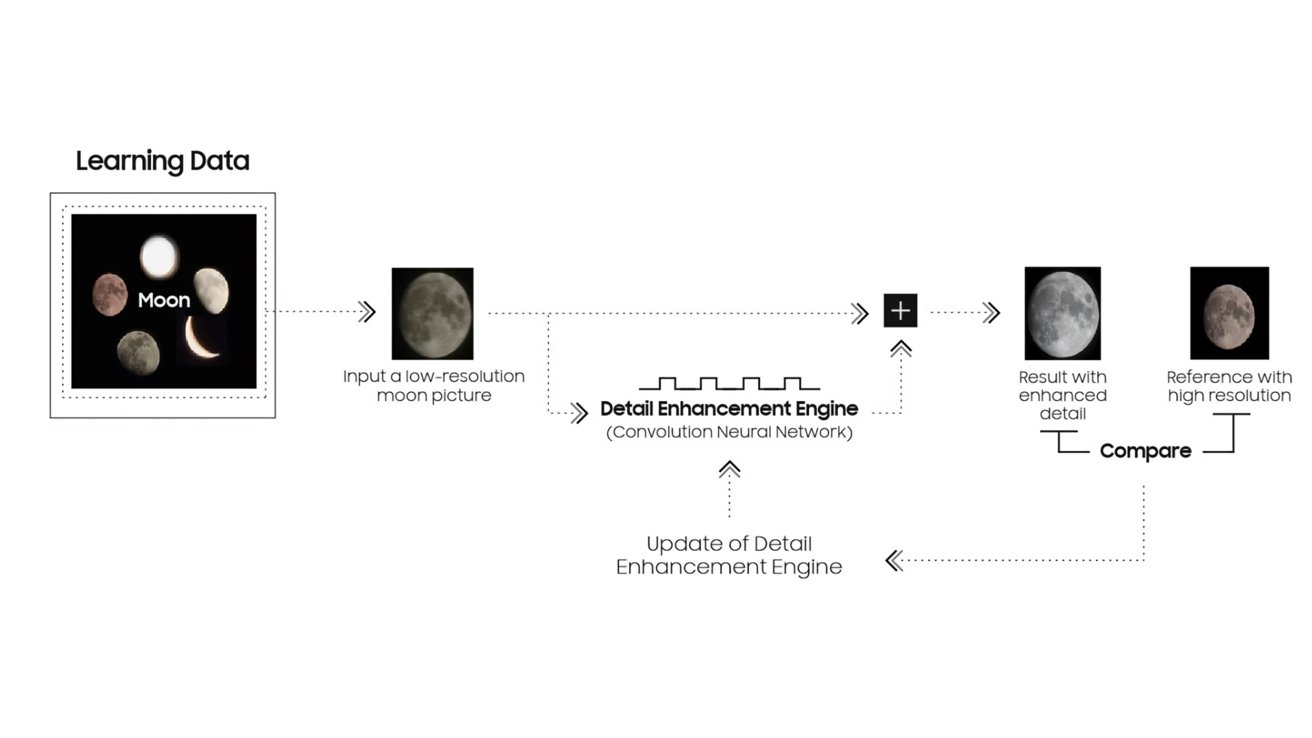

El algoritmo lunar de Samsung en acción. Crédito: u/ibreakphotos en Reddit

Samsung ha documentado cómo los teléfonos Samsung, desde el Galaxy S10, han procesado imágenes utilizando el reconocimiento y la alteración de objetos. El optimizador de escenas comenzó a reconocer la luna con elGalaxy S21.

Como describe el documento publicado recientemente, la “IA” reconoce la luna a través de los datos aprendidos, y la función del motor de mejora de detalles se aplica para hacer la foto más clara con la síntesis de múltiples fotogramas y el aprendizaje automático.

Básicamente, los dispositivos de Samsung reconocerán una luna no oscurecida y luego utilizarán otras imágenes de alta resolución y datos sobre la luna para sintetizar un mejor resultado. El resultado no es una imagen capturada por la cámara del dispositivo, sino algo nuevo y fabricado.

En general, este sistema es inteligente porque la luna tiene el mismo aspecto se mire desde donde se mire en la Tierra. Lo único que cambia es el color de la luz reflejada en su superficie y la fase de la propia luna. Realzar la luna en una foto siempre será un cálculo sencillo.

Tanto los dispositivos de Samsung como los de Apple toman una exposición de varias fotos para realizar cálculos avanzados. Ambos analizan múltiples imágenes capturadas para la mejor parte de cada uno y fusionarlos en una imagen superior. Sin embargo, Samsung añade un paso adicional para objetos reconocidos como la luna, que introduce nuevos datos de otras imágenes lunares de alta resolución para corregir la luna en la imagen capturada final.

Explicación del algoritmo lunar de Samsung. Crédito: Samsung

Esto no es necesariamente algo malo. Simplemente es algo que Samsung no ha dejado claro en su publicidad o en el marketing de sus productos, lo que puede llevar a confusión a los clientes.

El problema de este proceso, y la razón por la que existe un debate, es cómo afecta esto al futuro de la fotografía.

Resumiendo, la imagen final no representa lo que el sensor detectó y el algoritmo procesó. Representa una versión idealizada de lo que podría ser posible pero no lo es porque el sensor de la cámara y el objetivo son demasiado pequeños.

La inminente batalla por el realismo

Desde nuestro punto de vista, el principio clave de la fotografía con iPhone siempre ha sido el realismo y la precisión. Si hay un medio perfecto en la saturación, la nitidez y la exposición, Apple ha tendido cerca del centro en la última década, incluso si no siempre se ha mantenido perfectamente coherente.

Reconocemos que la fotografía es increíblemente subjetivo, pero parece que la fotografía Android, a saber, Samsung, se ha inclinado lejos de realismo. Una vez más, no es necesariamente negativo, sino una elección de opinión hecha por Samsung que los clientes tienen que abordar.

Para el asunto de esta discusión, los dispositivos de Samsung y Pixel han inclinado lentamente lejos de ese centro de representación realista ideal. Ellos están compitiendo por más saturación, nitidez, o la exposición similar al día por la noche.

El ejemplo anterior muestra cómo el Galaxy S22 Ultra favoreció más exposición y saturación, lo que llevó a una pérdida de detalle. Elecciones inocentes y de opinión, pero el iPhone 13 Pro, en este caso, se va a casa con una foto más detallada que se puede editar más tarde.

Esta diferencia en la forma de capturar las fotos se establece en los algoritmos opinionated utilizados por cada dispositivo. A medida que estos algoritmos avancen, las futuras decisiones fotográficas podrían dar lugar a elecciones más basadas en opiniones que no puedan revertirse posteriormente

Por ejemplo, al cambiar el aspecto de la luna mediante algoritmos avanzados sin avisar al usuario, esa imagen queda alterada para siempre para ajustarse a lo que Samsung considera ideal. Claro, si los usuarios saben desactivar la función, podrían hacerlo, pero es probable que no lo hagan.

Estamos entusiasmados con el futuro de la fotografía, pero como entusiastas de la fotografía, esperamos que no sea tan invisible. Al igual que el modo Retrato de Apple, Live Photos y otras técnicas de procesado, haz que sea opcional con interruptores obvios. Además, que sea reversible;

Al pulsar el disparador en la aplicación principal de la cámara de un dispositivo se debería tomar una foto representativa de lo que ve el sensor. Si el usuario quiere más, déjele elegir si lo añade antes o lo edita después.

De momento, prueba a hacer fotos del cielo nocturno con nada más que tu iPhone y un trípode. Funciona.

Por qué es importante

Es importante recalcar que no hay ningún problema en sustituir la fea bola brillante del cielo por una luna en condiciones, ni tampoco en eliminar gente o basura (o basureros) de una foto. Sin embargo, tiene que ser un proceso controlable, conmutable y visible para el usuario.

La fotografía computacional es el futuro, para bien o para mal

A medida que avancen los algoritmos, veremos imágenes más idealizadas y procesadas de los smartphones Android. Los peores delincuentes eliminarán o sustituirán objetos sin previo aviso;

Applemejorará inevitablemente su procesamiento de imágenes y sus algoritmos en el dispositivo. Pero, basándonos en cómo la empresa ha enfocado la fotografía hasta ahora, esperamos que lo haga respetando el deseo de realismo del usuario.

El tribalismo en la comunidad tecnológica siempre ha provocado debates entre los usuarios. Entre ellos, Mac o PC, iPhone o Android, y pronto, fotos reales o ideales.

Esperamos que Apple siga optando por el realismo y el control del usuario sobre las fotos en el futuro. Dar a una empresa el control total sobre lo que el usuario captura en una cámara, hasta alterar las imágenes para que coincidan con un ideal, no parece un futuro del que queramos formar parte.